Keras Selected

2014/04/13

-----

-----

如何深度,怎樣學習(三小時的深度學習入門介紹)

一、十個 Colab 上的 Keras 實作介紹。

二、實際動手跑一次 Simple MNIST convnet。

三、LeNet 與 AlexNet 核心技術與網路架構的網路資源。

-----

第一小時、介紹篇

-----

# History DL。

Alom, Md Zahangir, et al. "The history began from alexnet: A comprehensive survey on deep learning approaches." arXiv preprint arXiv:1803.01164 (2018).

https://arxiv.org/ftp/arxiv/papers/1803/1803.01164.pdf

機器學習與深度學習。

說明:

兩者核心皆為:資料、模型、訓練、推論。

一般而言,資料多時,深度學習的效果較好。

-----

# History DL。

Alom, Md Zahangir, et al. "The history began from alexnet: A comprehensive survey on deep learning approaches." arXiv preprint arXiv:1803.01164 (2018).

https://arxiv.org/ftp/arxiv/papers/1803/1803.01164.pdf

人工智慧、機器學習、深度學習。

說明:

機器學習是人工智慧的一支。深度學習是機器學習的一支。

脈衝神經網絡

譯自英文-尖峰神經網絡是與自然神經網絡更接近的人工神經網絡。除了神經元和突觸狀態之外,SNN還將時間概念納入其操作模型中。這個想法是SNN中的神經元不會在每個傳播週期中傳輸信息,而是僅在膜電位(與膜電荷相關的神經元的內在特性)達到特定值(稱為閾值)時才傳輸信息。 维基百科(英文)

-----

說明:

Keras 的實作設計很適合初學者,只要從頭到尾一直做就可以了。某個實作如果執行不順,可以練習一下 debug,也可以直接跳過去。

-----

◎ CV

-----

一、K01_Image classification from scratch(推薦:★★★★★ )

https://keras.io/examples/vision/image_classification_from_scratch/

說明:

二元分類,貓與狗。

-----

# LeNet

--

# LeNet

--

二、K02_Simple MNIST convnet(推薦:★★★★★ )

https://keras.io/examples/vision/mnist_convnet/

# LeNet。被引用 31707 次。經典的卷積神經網路,主要比 HDR 多了全連接層。

LeCun, Yann, et al. "Gradient-based learning applied to document recognition." Proceedings of the IEEE 86.11 (1998): 2278-2324.

http://yann.lecun.com/exdb/publis/pdf/lecun-01a.pdf

https://hemingwang.blogspot.com/2020/12/illustrated-lenet.html

說明:

0 到 9 的阿拉伯數字辨識。

-----

三、K03_Image segmentation with a U-Net-like architecture(推薦:★★★★★ )

https://keras.io/examples/vision/oxford_pets_image_segmentation/

說明:

Semantic Segmentation 語意分割,簡單說,把某一種類別的像素標示起來,譬如說把貓塗黑。語意分割特別可以用在醫學上與自駕車。

-----

四、Object Detection with RetinaNet

https://keras.io/examples/vision/retinanet/

說明:

偵測出物件的位置,然後偵測物件的類別。

-----

◎ NLP

-----

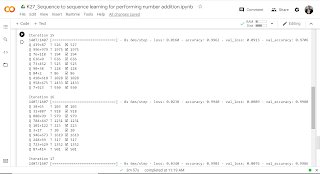

五、Sequence to sequence learning for performing number addition

https://keras.io/examples/nlp/addition_rnn/

# History DL。

Alom, Md Zahangir, et al. "The history began from alexnet: A comprehensive survey on deep learning approaches." arXiv preprint arXiv:1803.01164 (2018).

https://arxiv.org/ftp/arxiv/papers/1803/1803.01164.pdf

說明:

這是一個很簡單的實作,也很有趣。加法器。架構是 LSTM。資料可以自己生成。一開始錯很多,進行到十五次以後,基本上就正確了。

--

-----

六、Character-level recurrent sequence-to-sequence model

https://keras.io/examples/nlp/lstm_seq2seq/

說明:

用 LSTM 實現機器翻譯。

-----

# Transformer。被引用 13554 次。

Vaswani, Ashish, et al. "Attention is all you need." Advances in neural information processing systems. 2017.

https://papers.nips.cc/paper/7181-attention-is-all-you-need.pdf

七、Text classification with Transformer

https://keras.io/examples/nlp/text_classification_with_transformer/

說明:

用 Transformer 進行文本分類。

-----

# BERT。被引用 12556 次。

Devlin, Jacob, et al. "Bert: Pre-training of deep bidirectional transformers for language understanding." arXiv preprint arXiv:1810.04805 (2018).

https://arxiv.org/pdf/1810.04805.pdf

八、Text Extraction with BERT

https://keras.io/examples/nlp/text_extraction_with_bert/

說明:

用 BERT 進行文字抽取 Q&A。

-----

Rajpurkar, Pranav, Robin Jia, and Percy Liang. "Know what you don't know: Unanswerable questions for SQuAD." arXiv preprint arXiv:1806.03822 (2018).

-----

◎ Generative Deep Learning

-----

九、Neural style transfer

https://keras.io/examples/generative/neural_style_transfer/

說明:

風格轉換。

-----

十、Actor Critic Method

https://keras.io/examples/rl/actor_critic_cartpole/

說明:

學習到保持木棍的平衡。

-----

# DRL Survey

Arulkumaran, Kai, et al. "Deep reinforcement learning: A brief survey." IEEE Signal Processing Magazine 34.6 (2017): 26-38.

https://www.gwern.net/docs/rl/2017-arulkumaran.pdf

-----

第二小時、實作篇

-----

K02_Simple MNIST convnet(推薦:★★★★★ )

https://keras.io/examples/vision/mnist_convnet/

說明:

一、實作一個例子

二、切換至英文模式

三、切換至 GPU 模式

-----

第三小時、理論篇

-----

LeNet:

◎ Gradient Descent 梯度下降、Back Propagation 反向傳播。

AlexNet:

◎ ReLU 激活函數、Dropout 丟棄網路、

◎ Weight Decay 權重衰減、Momentum 動量。

-----

深度學習基礎理論

http://speech.ee.ntu.edu.tw/~tlkagk/courses_MLSD15_2.html

https://hemingwang.blogspot.com/2021/02/lee.html

-----

# LeNet。被引用 31707 次。經典的卷積神經網路,主要比 HDR 多了全連接層。

LeCun, Yann, et al. "Gradient-based learning applied to document recognition." Proceedings of the IEEE 86.11 (1998): 2278-2324.

http://yann.lecun.com/exdb/publis/pdf/lecun-01a.pdf

01a:LeNet

LeNet 論文(別人翻譯)

https://blog.csdn.net/qianqing13579/article/details/71076261

LeNet 簡介

https://hemingwang.blogspot.com/2020/12/lenet.html

LeNet 詳解

https://hemingwang.blogspot.com/2020/12/illustrated-lenet.html

-----

# AlexNet

Krizhevsky, Alex, Ilya Sutskever, and Geoffrey E. Hinton. "Imagenet classification with deep convolutional neural networks." Advances in neural information processing systems 25 (2012): 1097-1105.

https://proceedings.neurips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

01b:AlexNet

AlexNet 論文翻譯(已完成)

http://hemingwang.blogspot.com/2021/03/alexnetpaper-translation.html

AlexNet 簡介(已完成)

https://hemingwang.blogspot.com/2020/12/alexnet.html

AlexNet 詳解(已完成)

https://hemingwang.blogspot.com/2020/12/illustrated-alexnet.html

-----

https://hemingwang.blogspot.com/2020/12/illustrated-deep-learning.html

-----

No comments:

Post a Comment